For små to måneder siden begyndte jeg at kigge mig om efter en metode til at spore søgemaskinernes robotter i Google Analytics. Det kan for det første være meget sjovt at se hvornår de kommer forbi første gang efter en ny side er lanceret, men også efterfølgende at følge lidt med i hvor tit de kigger forbi og leder efter nyt indhold. Jeg fandt frem til en engelsk artikel, som er en oversættelse af en fransk artikel (ikke er tilgængelig mere), hvor de fortalte om et lille PHP script de havde lavet så det var muligt at spore søgerobotterne i Google Analytics.

Nåh, men jeg fandt altså frem til dette script som franskmændene havde lavet og fik det implementeret, og det fungerer faktisk rigtig godt, så derfor vil jeg lige dele det med jer her, samt lidt erfaringer med det. Da den oprindelige franske artikel ikke findes mere er der også begyndt at mangle nogle screenshots ovre i den engelsk artikel, så derfor har jeg lavet nogle nye som jeg vil forklare ud fra.

Opsætning i Google Analytics

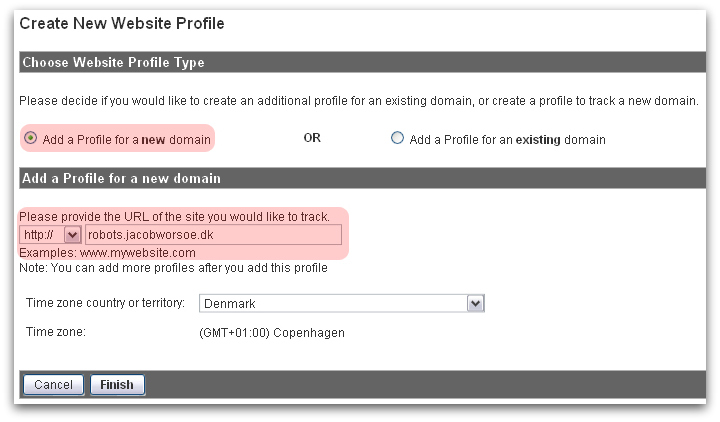

Først starter du med at oprette en ny profil til dit websted:

Sæt den øverste indstilling til “Add a profile for a new domain” og giv profilen et passende navn f.eks. “robots.jacobworsoe.dk”, sæt tidszonen korrekt og tryk på “finish”:

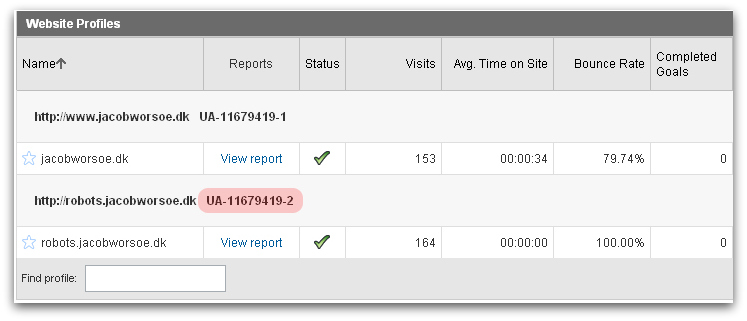

Derefter skal du downloade denne pakke med 3 php-filer og pak dem ud i din web-mappe. I den fil som hedder config.php skal der ændres 3 ting. Den første linje som hedder “$var_utmhn” skal indeholde navnet på dit domæne, i dette tilfælde “jacobworsoe.dk”. Den næste linje skal indeholde ID’et for den profil du lige har lavet. Den finder du ved at gå tilbage til oversigten i GA:

I den sidste linje skal du indsætte en værdi som du finder i den cookie som GA laver i din browser når du besøger din egen side. Bemærk er det kun er de tal der er markeret på billedet der skal med, altså kun dem før det første punktum:

Config.php kommer derved til at se således ud:

Nu skal du så bare sørge for at inkludere den fil der hedder “analytics.php” på alle dine sider og scriptet vil derefter sørge for at spore ikke mindre end 841 forskellige bots og så kan du holde øje med dem via den nye profil du har oprettet. De bliver altså ikke blandet sammen med dine “rigtige” besøgende som du tracker på almindelig vis. Jeg har lagt alle 3 php-filer i en mappe for sig som jeg kalder “analytics” og jeg inkluderer derfor filen med include(“analytics/analytics.php”);. I kommentarerne på den engelsk blog bliver der spurgt om man også skal indsætte GA tracking scriptet fra den nye profil, men det skal man ikke – det hele foregår via PHP scriptet, så det er ikke nødvendigt.

Hvad kan jeg så se?

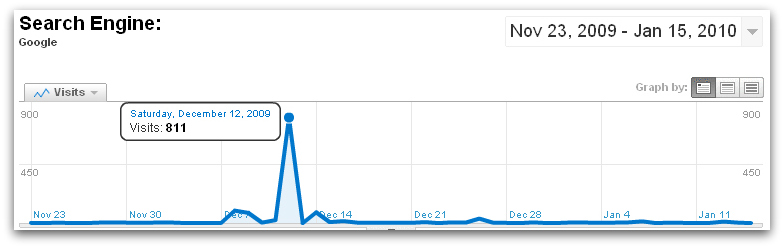

Nu har du adgang til en masse informationer om de bots der besøger din side. Jeg implementerede det på mit linkkatalog den 23. november og der er nu ved at være samlet lidt data vi kan kigge på. I Google Analytics går du ind under “Traffic sources – search engines” og får en liste over alle de forskellige bots der har crawlet din side:

Hvis man klikker på de enkelte bots kan man se at der faktisk er meget forskel på hvordan de crawler en side. Yahoo kommer f.eks. næsten hver dag og crawler et lille udsnit af sitet hver gang:

Google kommer derimod kun sjældent, men crawler så til gengæld 811 sider og holder sig så væk. Botten kommer dog forbi engang imellem når der kommer nyt indhold på sitet og crawler de nye sider, men alle de “gamle” sider bliver kun crawlet sjældent. I hvert fald på mit linkkatalog, men det afhænger selvfølgelig meget af sitet:

Man kan derudover også se hvilke sider der er besøgt og her er robots.txt en klar topscorer, men også de vigtigste undersider bliver crawlet ofte:

Til sidst et eksempel fra denne blog, hvor man kan se at Google har en bestemt bot som kun crawler rss-feeds. Det var ny viden for mig :)

Alt i alt et ganske smart lille trick som kan give lidt ny viden hvis man interesserer sig lidt for hvordan de forskellige bots egentlig opfører sig i praksis. Jeg glæder mig til at høre om det er noget I andre også finder sjovt?

17 kommentarer

Hæ… Sjovt lille hack. Man skal lige være opmærksom på at disse bot-besøg vil hæve antallet af ens sidevisninger. Som sådan ikke nogen katastrofe, men man bør lige holde det i baghovedet.

Vadskær: Hvis du tænker på at det ødelægger ens statistik (f.eks. giver en lavere konverteringsrate) så skal du ikke være nervøs. Fordi man laver en ny profil til at have dem i, så bliver de ikke talt med i ens oprindelige profil, så den indeholder fortsat kun "rigtige" mennesker. Alt det her bliver udelukkende registreret under den profil som hedder "robots.jacobworsoe.dk" eller hvad man nu vælger at kalde den :)

Nåe ja – det starter du jo også hele showet med. Altså at lave en ny profil. Det er generelt en god idé, når man går i gang med den slags cirkus-kunstner.

Synes stadig – det er et sjovt hack. Skal bestemt afprøve det selv.

Det er et fint hack, til at tracke robotter med, det erstatter ikke værdien af en logfil når lorten rammer ventilatoren og man skal finde en fejl. I det tilfælde er det kun god gammeldags logfilanalyse der virker.

Vadskær: Det glæder mig du kan bruge tricket :)

Torben: Logfiler er gode engang imellem, men det er nu meget sjovt at have samlet så meget statistik som muligt i Google Analytics :)

Nice – installeret, og så venter jeg bare på data :-)

Man kan jo skrive tykke bøger om hvad man kan med google analytics!

Tak for at dele dette tip med os!

Mikael: Ja, eller en hulens masse blogindlæg :)

Det var så lidt – håber du får noget spændende data ud af det.

Meget interessant indlæg… Jeg vil straks sætte det op, så der kan komme nogle data at analysere…

Takker ydmygt!

Janno: Fedt du kunne bruge det. Lad mig endelig høre hvis du får nogle spændende data ud af det :)

Jeg har forresten lige fundet ud af at Google-Feedfetcher er den bot som arbejder hos Google Reader. Så det er bare den der er inde og tjekke dit feed et par gange i timen og se om du har udgivet nogle nye indlæg siden sidst. Men det kan selvfølgelig også blive til en del besøg :)

Christian: Tak for roserne. Godt du kunne bruge det, og at det er til at forstå hvad jeg skriver :)

Hvad betyder crawler?

@gustav En crawler er et stykke software, som søgemaskinerne har udviklet. Den kravler rundt på nettet og følger (næsten) alle de links, den kan finde for at læse og indexere alle de sider, den støder på.

hmm min fejler hele tiden…..det må jeg lige kigge lidt nærmere på ;-)

Martin: Hvilken fejl får du?

Rigtig cool hack. Er dog ikke så velbevandret i analytics endnu, men må lege med det her i weekenden og se om jeg kan få det til at virke.